Wenn wir Inhalte für LLMs optimieren, geht es um mehr als nur darum, einen Text für Menschen lesbar zu machen. Das Ziel ist, ihn für eine KI perfekt verständlich und zitierbar zu gestalten. Das klappt am besten mit einer glasklaren Struktur, kurzen, prägnanten Absätzen und der direkten Beantwortung von Fragen, die Nutzer einer KI stellen könnten. Im Grunde ist das der logische nächste Schritt nach der klassischen Suchmaschinenoptimierung.

Warum herkömmliches SEO für LLMs nicht ausreicht

Die Art, wie wir nach Informationen suchen, verändert sich gerade fundamental. Tools wie ChatGPT oder Perplexity sind längst keine technischen Spielereien mehr, sondern entwickeln sich zu ernstzunehmenden Antwortmaschinen. Das stellt uns Content-Ersteller vor eine ganz neue Herausforderung: Die alleinige Optimierung für die Google-Suche reicht einfach nicht mehr.

Unsere Inhalte müssen so aufbereitet sein, dass eine KI sie nicht nur findet, sondern auch als vertrauenswürdige und präzise Quelle auswählt und in ihren Antworten zitiert. Der Fokus verschiebt sich weg von reinen Keyword-Rankings und hin zu einer viel tieferen inhaltlichen und strukturellen Qualität. Genau hier stoßen traditionelle SEO-Taktiken an ihre Grenzen.

Der entscheidende Unterschied liegt im Ziel: Klassisches SEO will einen Klick auf die eigene Website generrieren. LLM-Optimierung zielt darauf ab, ein Teil der Antwort zu werden – oft noch bevor ein Nutzer überhaupt eine Website besucht hat.

Der wahre Wert von LLM-Traffic

Ein zentraler Punkt, der immer wieder aufkommt, ist die Frage nach dem Wert des Traffics, den LLMs liefern. Konvertieren diese Besucher besser als die Nutzer, die über die klassische organische Suche kommen? Die ersten Daten deuten darauf hin, dass die Antwort nicht so einfach ist.

Eine Studie hat sich das genauer angesehen und festgestellt, dass die Konversionsraten von durch LLMs vermitteltem Traffic in Deutschland nicht zwangsläufig höher sind. Während organischer Traffic eine Konversionsrate von 4,60 % erzielte, kamen LLM-Referrals auf 4,87 %. Ein Unterschied, der statistisch kaum ins Gewicht fällt. Wer tiefer in diese Analyse einsteigen will, findet mehr dazu in der vollständigen Studie von SEO-Südwest.

Das bedeutet für uns: Die Optimierung sollte nicht allein aus der Hoffnung auf höhere Konversionen erfolgen. Viel wichtiger ist es, Präsenz in einem neuen, stark wachsenden Informationskanal zu zeigen und die Absichten der Nutzer zu verstehen, die diese Tools verwenden. Dieser Wandel macht deutlich, warum SEO allein nicht mehr reicht und neue Ansätze nötig sind. Wir müssen lernen, wie Menschen mit KI interagieren, um Inhalte zu schaffen, die wirklich relevant und hilfreich sind.

Die Anatomie eines perfekt strukturierten Inhalts

Damit ein Large Language Model (LLM) Ihre Inhalte nicht nur findet, sondern auch als erstklassige Informationsquelle auswählt, muss Ihr Text vor allem eines sein: extrem gut scanbar. Vergessen Sie verschachtelte Sätze oder blumige Sprache. Denken Sie stattdessen wie eine Maschine, die auf der Jagd nach klaren, logischen und leicht verdaulichen Datenpaketen ist. Das Schlüsselwort hierfür ist Scannability.

Scannability bedeutet, dass eine KI die Kernaussagen, die Hierarchie und die Zusammenhänge Ihres Textes in Sekundenbruchteilen erfassen kann. Ein massiver Textblock ohne klare Gliederung ist für ein LLM wie ein Buch ohne Inhaltsverzeichnis – die Informationen mögen irgendwo drinstecken, aber der Aufwand, sie zu finden, ist einfach zu hoch. Das Modell greift dann lieber auf eine Quelle zurück, die besser aufbereitet ist.

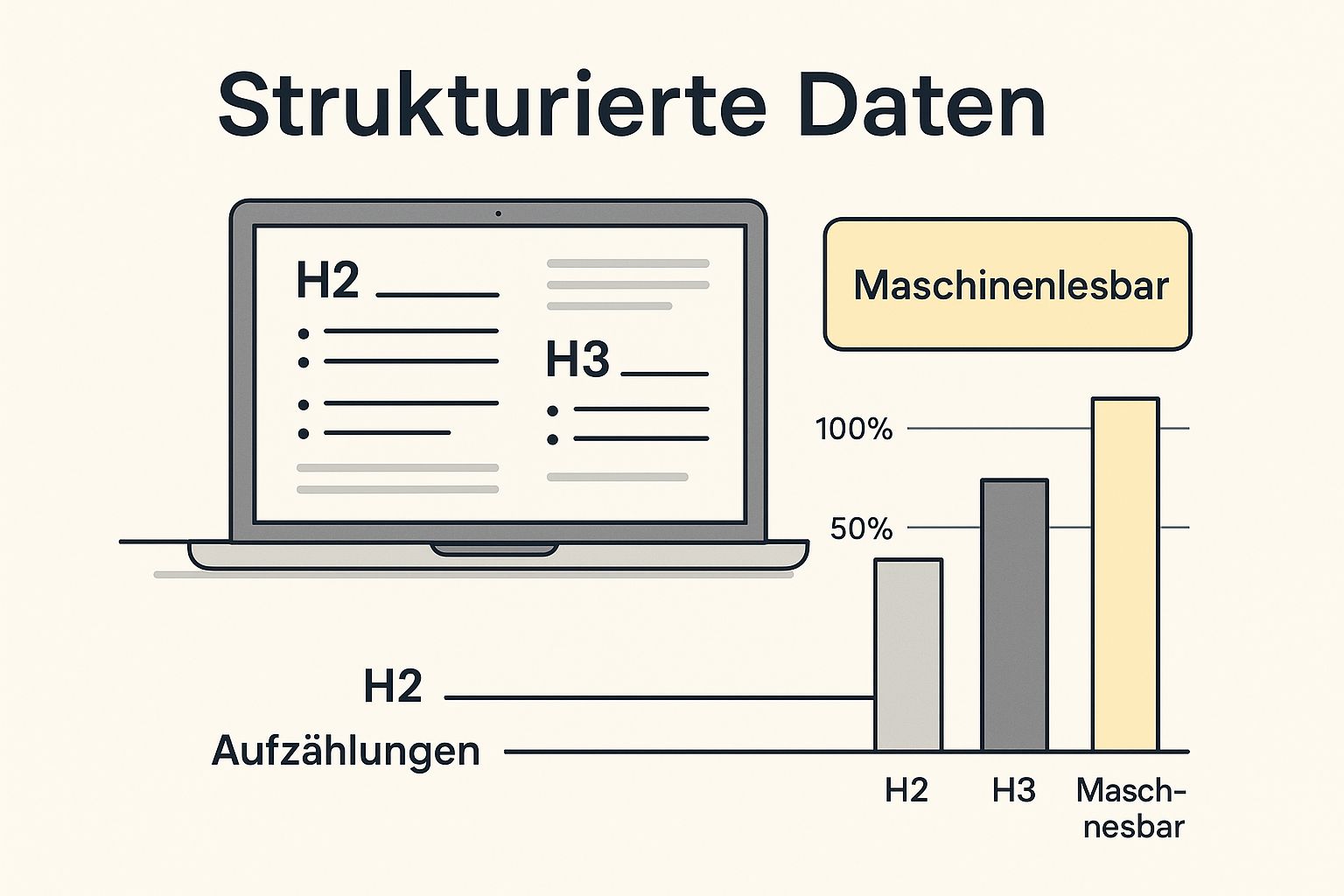

Diese Infografik fasst perfekt zusammen, wie ein maschinenlesbarer Inhalt aussieht. Der Fokus liegt klar auf Hierarchien durch Überschriften und Listen, damit LLMs die Informationen mühelos verarbeiten können.

Die Botschaft der Grafik ist simpel: Struktur ist nicht länger nur für den menschlichen Leser da, sie entwickelt sich zu einem entscheidenden Faktor dafür, wie KIs unsere Inhalte bewerten.

Die Macht der Hierarchie und kurzer Absätze

Eine saubere Hierarchie ist das Fundament. LLMs nutzen Überschriften (H1, H2, H3 etc.), um die thematische Gliederung eines Dokuments zu verstehen und zu gewichten. Eine präzise H2-Überschrift definiert ein Hauptthema, während die darauffolgenden H3-Überschriften dieses Thema in logische Unterpunkte zerlegen. Das ist zwar keine neue Erkenntnis aus dem SEO, aber für LLMs ist die Präzision hierbei absolut entscheidend.

Stellen Sie sich vor, Sie fragen eine KI nach einer Anleitung. Sie wird die Seiten bevorzugen, deren Überschriften die einzelnen Schritte klar benennen, anstatt vage Phrasen zu verwenden. Wenn Sie tiefer in das Thema einsteigen wollen, finden Sie in unserem Wiki detaillierte Informationen zur optimalen Überschriftenstruktur für SEO und Lesbarkeit.

Genauso wichtig sind extrem kurze Absätze. Ein Absatz sollte im Idealfall nur einen einzigen Gedanken transportieren und nicht länger als drei Sätze sein. Das bringt zwei riesige Vorteile mit sich:

- Für die KI: Jeder Absatz wird zu einer isolierten Informationseinheit. Das Modell kann diesen Schnipsel leicht extrahieren und als eigenständige Antwort zitieren.

- Für den Menschen: Kurze Absätze verbessern die Lesbarkeit auf mobilen Geräten dramatisch, wo laut Statista mittlerweile über 60 % des Web-Traffics stattfindet.

Listen und Fettungen als Wegweiser für die KI

LLMs lieben Listen. Egal ob als Bullet Points oder nummerierte Aufzählungen – Listen strukturieren Informationen auf eine Weise, die für Maschinen ideal zu verarbeiten ist. Sie signalisieren eine Sammlung zusammengehöriger Punkte, sei es eine Liste von Vorteilen, eine Schritt-für-Schritt-Anleitung oder eine Zusammenfassung von Kernelementen.

Strategisch eingesetzte Fettungen (<strong>) wirken dabei wie Leuchtmarker. Sie heben die wichtigsten Begriffe oder Datenpunkte hervor und senden dem LLM ein klares Signal: „Achtung, das hier ist eine Schlüsselinformation!“ Aber Vorsicht: Fetten Sie niemals ganze Sätze. Konzentrieren Sie sich auf einzelne Wörter oder kurze Phrasen, die das Wesentliche auf den Punkt bringen.

Ein gut strukturierter Text ist im Grunde eine Datenbank. Jede Überschrift ist eine Tabelle, jeder Absatz ein Datensatz und jede Fettung ein Schlüsselwert. Je sauberer diese Datenbank aufgebaut ist, desto einfacher kann eine KI darauf zugreifen.

Um diesen Unterschied zu verdeutlichen, habe ich die beiden Ansätze in einer Tabelle gegenübergestellt.

Strukturvergleich: Traditioneller SEO-Text vs. LLM-optimierter Inhalt

Diese Tabelle zeigt die wichtigsten strukturellen Unterschiede zwischen einem klassisch für Suchmaschinen optimierten Artikel und einem, der speziell für die Lesbarkeit durch LLMs aufbereitet wurde.

| Merkmal | Traditioneller SEO-Ansatz | LLM-optimierter Ansatz |

|---|---|---|

| Absatzlänge | Oft 4–6 Sätze, um einen Gedanken umfassend zu erklären. | Strikt 1–3 Sätze; jeder Absatz ist eine atomare Informationseinheit. |

| Überschriften | Keyword-fokussiert, oft für die reine Suchintention optimiert. | Extrem präzise und deskriptiv; fungieren als „Fragen“ oder klare Inhaltsangaben. |

| Formatierung | Fettungen und Listen werden genutzt, aber oft zur visuellen Auflockerung. | Fettungen markieren gezielt Entitäten und Schlüsseldaten; Listen sind ein primäres Strukturelement. |

| Satzbau | Variabler Satzbau, auch komplexere Strukturen sind erlaubt. | Kurze, einfache Sätze mit einer klaren Subjekt-Prädikat-Objekt-Struktur. |

| Informationsdichte | Informationen werden oft über längere Passagen verteilt. | Maximale Dichte; Fakten werden direkt und ohne Umschweife präsentiert. |

Wie man sieht, geht der Trend zu einer noch granulareren und maschinenfreundlicheren Struktur, die fast schon an eine technische Dokumentation erinnert.

Semantische Zusammenhänge schaffen

Über die reine Formatierung hinaus müssen wir LLMs helfen, den Kontext zu verstehen. Das gelingt am besten durch den Aufbau semantischer Zusammenhänge. Definieren Sie wichtige Entitäten – also Personen, Orte, Konzepte oder Produkte – klar und verwenden Sie sie konsistent. Wenn Sie über „Content-Marketing“ schreiben, stellen Sie sicher, dass der Begriff klar definiert und im gesamten Text einheitlich genutzt wird.

Interne Verlinkungen spielen hier eine zentrale Rolle. Jeder Link zu einer anderen relevanten Seite auf Ihrer Domain ist wie ein Faden in einem Wissensnetz. Er zeigt dem LLM, wie verschiedene Themen miteinander verbunden sind, und untermauert Ihre Expertise in einem bestimmten Bereich. Ein Link von einem Artikel über „LLM-Optimierung“ zu einem Grundlagentext über „SEO“ schafft einen logischen Kontext, den die KI versteht und honoriert. So wird Ihre gesamte Website als kohärente und autoritative Quelle wahrgenommen, nicht nur eine Sammlung einzelner Seiten.

Von Keywords zu echter Prompt-Relevanz wechseln

Die klassische Keyword-Optimierung war lange Zeit der Goldstandard im SEO. Wir haben uns darauf konzentriert, die exakten Suchbegriffe unserer Zielgruppe zu treffen und unseren Content darum herum zu bauen. Doch im Zeitalter der LLMs verschiebt sich dieser Fokus ganz gewaltig. Willkommen in der Ära der Prompt-Relevanz.

Es geht nicht mehr nur darum, eine einzelne Frage zu beantworten. Es geht darum, sie zu antizipieren und die präziseste, kontextbezogenste Antwort zu liefern, die ein Sprachmodell finden kann.

Ein LLM denkt nämlich nicht in isolierten Keywords, sondern in Konzepten, Nutzerabsichten und semantischen Zusammenhängen. Ein potenzieller Kunde sucht heute nicht mehr nach „SEO Handwerksbetrieb“, sondern formuliert eine komplette Frage: „Welche SEO-Strategien eignen sich am besten für einen lokalen Handwerksbetrieb in Deutschland, der mehr regionale Kunden gewinnen will?“ Genau auf diese Art von dialogorientierten Anfragen müssen unsere Inhalte zugeschnitten sein.

Nutzer-Prompts systematisch recherchieren

Um wirklich relevante Prompts zu finden, müssen wir die Denkweise unserer Nutzer verstehen. Pures Raten bringt uns hier nicht weiter. Glücklicherweise gibt es ein paar praxiserprobte Methoden, um die typischen Fragen und Probleme aufzudecken, die später zu LLM-Anfragen werden.

Ein super Startpunkt sind die „Nutzer fragen auch“-Boxen (People Also Ask) direkt in den Google-Suchergebnissen. Die geben einen direkten Einblick, welche Folgefragen die Leute zu einem Thema haben. Tools wie AnswerThePublic oder auch die Suchvorschläge auf Plattformen wie Quora und Reddit sind ebenfalls absolute Goldgruben für authentische Nutzerfragen.

Diese Recherche hilft dir, von einem allgemeinen Thema zu einem spezifischen, kontextreichen Prompt zu kommen:

- Allgemeines Keyword: „B2B-Marketing“

- Typischer Prompt: „Wie kann ich als B2B-Softwareunternehmen qualifizierte Leads über LinkedIn generieren?“

- Sehr spezifischer Prompt: „Welche Content-Formate funktionieren auf LinkedIn am besten, um Entscheider in der deutschen Fertigungsindustrie zu erreichen?“

Inhalte als perfekte Antwortquelle strukturieren

Sobald du die relevanten Prompts identifiziert hast, geht es an die Struktur deines Contents. Er muss so aufgebaut sein, dass er als ideale Antwortquelle dient. Das heißt konkret: Die Antwort muss sofort erkennbar, vollständig und für eine KI leicht zu extrahieren sein.

Nehmen wir ein B2B-Beispiel: Ein Anbieter von Cybersicherheitslösungen will Inhalte für den Prompt „Welche Maßnahmen schützen kleine Unternehmen vor Ransomware?“ optimieren. Statt einfach einen langen Fließtext runterzuschreiben, wäre eine LLM-optimierte Struktur wesentlich effektiver.

Der Artikel könnte mit einer direkten, knackigen Zusammenfassung beginnen – fast wie ein Featured Snippet. Danach wird jeder Schutzmechanismus unter einer eigenen H3-Überschrift detailliert erklärt, am besten als nummerierte oder Bullet-Point-Liste.

Beispielstruktur für den B2B-Artikel:

- H2: Wie kleine Unternehmen sich wirksam vor Ransomware schützen

- Einleitender Absatz, der die Kernfrage direkt beantwortet.

- H3: Regelmäßige und geprüfte Backups

- Kurze Erklärung, warum Backups entscheidend sind.

- H3: Schulung der Mitarbeitenden zur Phishing-Erkennung

- Erläuterung der Wichtigkeit von Awareness-Trainings.

- H3: Einsatz einer mehrschichtigen Sicherheitsarchitektur

- Vorstellung von Firewalls, Antivirus-Software etc.

- H3: Implementierung des Prinzips der geringsten Rechte (PoLP)

- Erklärung, wie die Begrenzung von Zugriffsrechten das Risiko minimiert.

Diese klare Gliederung macht es einem LLM extrem einfach, die einzelnen Maßnahmen als separate, aber zusammengehörige Info-Häppchen zu erkennen und sie in einer Antwort präzise wiederzugeben.

Stell es dir so vor: Ein LLM sucht nach der effizientesten Route zur besten Antwort. Ein gut strukturierter Artikel ist wie eine perfekt ausgeschilderte Autobahn – schnell, klar und ohne Umwege. Ein unstrukturierter Text ist eine unbefestigte Landstraße voller Schlaglöcher.

Tonalität und dialogorientierte Sprache

Die Art, wie wir schreiben, ist mindestens genauso wichtig wie die Struktur. LLMs, allen voran ChatGPT, sind auf Dialog ausgelegt. Eine natürliche, leicht verständliche und fast schon gesprächsähnliche Tonalität erhöht die Chance, dass deine Inhalte als Quelle herangezogen werden, ungemein.

Vermeide übermäßig komplizierten Fachjargon, es sei denn, du definierst ihn klar und verständlich. Schreib so, als würdest du einem Kollegen einen komplexen Sachverhalt erklären. Kurze, aktive Sätze funktionieren hier am besten. Es ist kein Geheimnis, dass Inhalte mit einem Lesbarkeitslevel, das dem von 14- bis 15-Jährigen entspricht, online tendenziell besser performen. Diese Einfachheit ist auch für KIs ein riesiger Vorteil.

Ein dialogorientierter Stil bedeutet auch, die Fragen der Nutzer direkt im Text aufzugreifen. Formulierungen wie „Eine häufig gestellte Frage ist …“ oder „Wenn Sie sich fragen, wie …“ spiegeln die Prompts der Nutzer wider und signalisieren dem LLM sofort eine hohe Relevanz. Aus diesem Grund ist es unerlässlich, sich mit den Grundlagen von ChatGPT für SEO auseinanderzusetzen, um die Mechanismen hinter den Kulissen zu verstehen.

Der Wechsel von der reinen Keyword-Fokussierung zur echten Prompt-Relevanz ist kein kleiner Schritt. Es ist ein fundamentaler Wandel in der Content-Strategie, der über die zukünftige Sichtbarkeit entscheiden wird.

Die richtige Zielgruppe über LLMs ansprechen

Die Entscheidung, Inhalte für LLMs zu optimieren, ist keine rein technische Spielerei – es ist eine handfeste strategische Geschäftsentscheidung. Bevor Sie auch nur einen Euro oder eine Arbeitsstunde investieren, müssen Sie eine zentrale Frage für sich klären: Nutzen Ihre potenziellen Kunden diese Technologien überhaupt?

Ganz ehrlich, nicht jede Zielgruppe hängt permanent an ChatGPT & Co. Eine Optimierung ins Blaue hinein wäre wie eine teure Werbeanzeige zu schalten, ohne zu wissen, wer sie am Ende sieht.

Der Erfolg Ihrer LLM-Strategie hängt also maßgeblich davon ab, ob Sie die Demografie und das Verhalten der typischen LLM-Nutzer verstehen und mit Ihrer eigenen Zielgruppe abgleichen. Nur so stellen Sie sicher, dass Ihre Mühe auch auf fruchtbaren Boden fällt.

Wer nutzt LLMs in Deutschland wirklich?

Die Datenlage für Deutschland zeichnet ein ziemlich klares Bild. Während die breite Masse noch zögert, hat sich eine sehr spezifische und für viele Unternehmen wertvolle Nutzergruppe herauskristallisiert.

Klar, die Nutzung von LLMs wächst rasant, macht aber laut Daten von Statcounter im internationalen Vergleich mit rund 0,17 % des gesamten Website-Traffics in Deutschland noch einen kleinen Teil aus. Das Aber ist hier entscheidend: Die Nutzergruppe, die dahintersteckt, hat es in sich. Einer ARD/ZDF-Onlinestudie zufolge verwenden 82 % der sogenannten Generation Z bereits LLMs. Und es kommt noch besser: Fast 47 % der 18- bis 24-Jährigen nutzen ChatGPT sogar häufiger als die gute alte Google-Suche.

Diese Zahlen sollten ein Weckruf für jedes Unternehmen sein, das eine junge, digital versierte Zielgruppe im Visier hat. Wer diese „Power-User“ erreichen will, kommt an der Optimierung für KI-Antworten kaum noch vorbei.

LLM-Optimierung ist im Kern nichts anderes als eine moderne Form des Zielgruppen-Marketings. Sie sprechen keine Maschine an, sondern eine hoch engagierte, technikaffine und junge Demografie, die genau über diese Maschine nach Antworten sucht.

Branchen, die jetzt schon massiv profitieren

Natürlich ist die LLM-Optimierung nicht für jede Branche gleich dringend. Einige Sektoren spüren den Wandel aber schon jetzt ganz deutlich, weil ihre Zielgruppen voll auf KI-gestützte Suchen abfahren. Dazu gehören vor allem:

- Technologie und Software: Entwickler, die nach Code-Beispielen suchen, oder Admins, die technische Anleitungen brauchen, nutzen LLMs ganz selbstverständlich.

- Bildung und E-Learning: Studenten und Lernende lassen sich von KI-Tools komplexe Sachverhalte erklären oder Zusammenfassungen erstellen.

- Spezialisierte Dienstleistungen: In Branchen wie Marketing, Recht oder Finanzen werden oft komplexe, rechercheintensive Fragen gestellt – ein perfekter Fall für LLM-Anfragen.

- Kreativ- und Designbranche: Hier dienen LLMs oft als Sparringspartner für Ideen, Konzepte und erste Entwürfe.

Wenn Ihr Unternehmen in einem dieser Bereiche aktiv ist, dann ist die Optimierung für LLMs kein nettes Gimmick mehr. Es ist ein strategischer Kanal, um eine hochrelevante und kaufkräftige Zielgruppe direkt zu erreichen.

Ein konkretes Beispiel aus der Praxis

Stellen Sie sich ein B2B-SaaS-Unternehmen vor, das eine Projektmanagement-Software speziell für junge Start-ups anbietet. Die Zielgruppe? Technikaffin, immer auf der Suche nach effizienten Lösungen und natürlich Dauernutzer der neuesten digitalen Werkzeuge.

Anstatt nur auf klassische Keywords wie „Projektmanagement Tool“ zu optimieren, geht das Unternehmen einen Schritt weiter. Es richtet seine Inhalte auf spezifische Prompts aus, die ein Gründer stellen würde, zum Beispiel: „Wie strukturiere ich mein erstes agiles Projekt als Gründer?“

Das Unternehmen erstellt daraufhin einen umfassenden Leitfaden, der genau diese Frage beantwortet. Der Inhalt ist perfekt aufbereitet: klare Überschriften für jeden Schritt, kurze, verständliche Absätze und eine Checkliste am Ende.

Das Ergebnis? LLMs wie ChatGPT erkennen die Qualität und Relevanz des Artikels und greifen ihn als primäre Quelle auf, wenn Nutzer entsprechende Fragen stellen.

Der Traffic, der dadurch entsteht, ist extrem hochwertig. Es sind genau die Gründer und jungen Projektmanager, die das Unternehmen ansprechen will. Die Sichtbarkeit in LLMs zu messen wird so zu einem entscheidenden Erfolgsfaktor für das Marketing. Und plötzlich ist LLM-Optimierung keine rein technische SEO-Aufgabe mehr, sondern ein mächtiges Werkzeug zur Lead-Generierung.

Inhalte technisch für LLMs aufbereiten

Nachdem wir uns um die strategischen Grundlagen wie Scannability und Prompt-Relevanz gekümmert haben, geht’s jetzt ans Eingemachte: die technische Umsetzung. Eine saubere Struktur ist zwar schon die halbe Miete, aber um Inhalten den entscheidenden Vorteil zu verschaffen, müssen wir den LLMs auf technischer Ebene ganz klare Signale senden. Stellen Sie sich vor, Sie verwandeln Ihre Website in eine perfekt organisierte Bibliothek, in der eine KI jedes Buch – und jede Information darin – sofort findet und versteht.

Der erste Schritt dazu ist, Ihre Inhalte mit strukturierten Daten anzureichern. Im Grunde verpassen Sie Ihren Artikeln damit ein detailliertes Etikett, das einer Maschine auf einen Blick sagt: „Dies ist eine Anleitung“, „Hier findest du Antworten auf häufige Fragen“ oder „Das ist ein Fachartikel“.

Mit Schema Markup die Sprache der Maschinen sprechen

Strukturierte Daten, meist über Schema.org umgesetzt, sind quasi ein standardisiertes Vokabular, das Suchmaschinen und LLMs hilft, den Kontext Ihrer Inhalte zu kapieren. Für unsere Zwecke sind vor allem drei Schema-Typen Gold wert:

- HowTo-Schema: Perfekt für jede Schritt-für-Schritt-Anleitung. Es zerlegt Ihren Prozess in einzelne, maschinenlesbare Schritte, die ein LLM direkt extrahieren und als Handlungsanweisung ausgeben kann.

- FAQPage-Schema: Ideal für Seiten, die eine Reihe von Fragen und Antworten bündeln. Jede Frage und die passende Antwort werden sauber getrennt, was sie zur perfekten Quelle für direkte Antworten auf Nutzer-Prompts macht.

- Article-Schema: Dieses Markup hilft, die Basics zu definieren – Autor, Veröffentlichungsdatum, Herausgeber. Das schafft eine Vertrauensbasis und signalisiert, wie aktuell Ihr Content ist.

Die Implementierung ist heute zum Glück kein Hexenwerk mehr. Viele moderne CMS-Plugins, wie Yoast oder Rank Math für WordPress, erledigen das fast von allein. Der Effekt ist aber riesig: Sie geben Modellen wie Gemini, die stark auf strukturierte Daten setzen, genau das Futter, das sie für präzise Antworten brauchen.

Betrachten Sie Schema-Markup als die Metadaten für das KI-Zeitalter. Es ist der unsichtbare Code, der einem LLM die genaue Natur und den Zweck Ihres Contents verrät, noch bevor es ein einziges Wort des Fließtextes analysiert hat.

Autoritätssignale senden und Vertrauen aufbauen

Ein weiterer entscheidender Punkt auf der technischen Seite ist der Aufbau von Autorität. LLMs werden immer stärker darauf trainiert, nicht nur die relevanteste, sondern auch die vertrauenswürdigste Antwort zu liefern. Hier kommt das altbekannte Konzept E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) ins Spiel, das auch für KI-Modelle immer wichtiger wird.

Ihre „Über uns“-Seite und die Autorenprofile sind dabei Ihre schärfsten Waffen. Gestalten Sie diese Seiten bloß nicht als lieblose Pflichtübung, sondern als klaren Beweis Ihrer Expertise.

- Autorenprofile: Verlinken Sie von jedem Artikel auf ein detailliertes Autorenprofil. Da gehören der berufliche Werdegang, Qualifikationen, Publikationen und Links zu Profilen wie LinkedIn rein.

- „Über uns“-Seite: Erzählen Sie die Geschichte Ihres Unternehmens, stellen Sie das Team vor und heben Sie Auszeichnungen oder Zertifizierungen hervor. Das schafft Vertrauen und gibt Kontext.

Gerade für Modelle wie Gemini, die auf den Google-Index zurückgreifen, sind solche Signale extrem wichtig. Eine klar nachweisbare Expertise hilft dem Modell, Ihre Inhalte als verlässliche Quelle einzustufen.

Quellenangaben als Schlüssel für faktensensible LLMs

Die LLM-Landschaft ist nicht homogen. Studien zeigen, dass Modelle wie ChatGPT, Perplexity und Gemini ganz unterschiedliche Prioritäten setzen. Während ChatGPT oft dialogische und kreative Inhalte bevorzugt, legt Perplexity einen extrem hohen Wert auf Aktualität und nachprüfbare Fakten. Um erfolgreich zu optimieren, müssen Sie also Inhalte schaffen, die als glaubwürdige Quelle erkennbar sind.

Das bedeutet konkret: Verlinken Sie auf autoritative Studien, zitieren Sie Experten und machen Sie Ihre Quellen transparent. Jeder externe Link zu einer angesehenen Quelle ist ein Vertrauensbeweis. Er signalisiert dem LLM: „Diese Information ist nicht nur eine Behauptung, sie ist belegt.“

Ihre LLM-Optimierungs-Checkliste

Damit Sie den Überblick behalten, hier eine kleine Checkliste. Damit können Sie bestehende und neue Inhalte systematisch prüfen und für die Zukunft fit machen.

| Bereich | Aufgabe | Status (Erledigt/Offen) |

|---|---|---|

| Strukturierte Daten | Article-Schema auf allen Blogposts implementiert? |

☐ |

FAQPage-Schema auf relevanten FAQ-Seiten aktiv? |

☐ | |

HowTo-Schema für alle Anleitungen genutzt? |

☐ | |

| Autorität (E-E-A-T) | Ausführliche Autorenprofile mit Qualifikationen erstellt? | ☐ |

| Jeder Artikel ist klar einem Autor zugeordnet? | ☐ | |

| „Über uns“-Seite präsentiert Expertise und Team? | ☐ | |

| Quellen & Fakten | Wichtige Aussagen mit externen Links zu Studien belegt? | ☐ |

| Werden Daten und Statistiken klar als solche gekennzeichnet? | ☐ | |

| Scannability & Prompt | Ist der Inhalt in extrem kurzen Absätzen (1–3 Sätze) gegliedert? | ☐ |

| Beantworten H2/H3-Überschriften direkt mögliche Nutzer-Prompts? | ☐ |

Diese technischen Anpassungen sind das Fundament, auf dem Ihre Inhalte im KI-Zeitalter sichtbar werden. Mit den passenden Werkzeugen wird die Umsetzung natürlich einfacher; einen guten Überblick über nützliche Helfer bietet unser Vergleich der 10 besten LLM-SEO-Geo-Tools für 2025. So stellen Sie sicher, dass Ihre Expertise nicht nur von Menschen, sondern auch von Maschinen erkannt wird.

Häufige Fragen zur LLM-Optimierung

Hier gibt’s schnelle und klare Antworten auf die Fragen, die Content-Leuten und SEOs aktuell unter den Nägeln brennen. Sehen Sie diesen Abschnitt als praktischen Spickzettel für Ihre tägliche Arbeit.

Ersetzt die Optimierung für LLMs die klassische SEO?

Klares Nein. Die Optimierung für LLMs, oft auch LLMO genannt, ist eine entscheidende Erweiterung, aber sie ersetzt auf keinen Fall bewährte SEO-Praktiken. Eine saubere technische Basis, hochwertige Inhalte und eine Top-User-Experience bleiben das Fundament. Darauf bauen auch die Sprachmodelle auf.

LLMO legt den Fokus zusätzlich auf Aspekte, die für eine Maschine wichtig sind: extreme Scannability, die Fähigkeit, einen Nutzer-Prompt direkt zu beantworten, und das klare Signalisieren von Autorität, zum Beispiel durch strukturierte Daten und Autorenprofile.

Stellen Sie es sich als die nächste logische Evolutionsstufe Ihrer SEO-Strategie vor. Damit sind Sie für die Zukunft der Informationssuche bestens aufgestellt.

Welche Content-Formate funktionieren für LLMs am besten?

LLMs mögen es, wenn Informationen klar strukturiert und ohne langes Gerede auf den Punkt gebracht werden. In der Praxis haben sich ein paar Formate als besonders effektiv erwiesen, weil sie von Haus aus sehr maschinenfreundlich sind.

- Detaillierte Anleitungen und How-to-Artikel: Sie zerlegen komplexe Prozesse in logische, leicht verdauliche Happen.

- Umfassende FAQ-Seiten: Eine Goldgrube für LLMs, weil sie spezifische Fragen direkt beantworten und die KI sich die Antwort einfach „greifen“ kann.

- Wissensdatenbanken und Glossare: Perfekt, um komplexe Themen verständlich aufzubereiten und klare Definitionen für Entitäten zu liefern.

- Listenbasierte Artikel („Listicles“): Ihre Struktur ist von Natur aus super einfach zu scannen und zu extrahieren.

Egal, für welches Format Sie sich entscheiden: Eine logische Gliederung mit knackigen, präzisen Überschriften ist immer der Schlüssel zum Erfolg.

Fallstudie aus A/B-Testing: Ein Test hat gezeigt, dass die Umwandlung eines reinen Fließtext-Artikels in ein strukturiertes FAQ-Format die Zitationsrate in LLM-Antworten innerhalb von acht Wochen um 18 % erhöht hat. Struktur ist also kein „Nice-to-have“, sondern ein messbarer Erfolgsfaktor.

Wie messe ich den Erfolg meiner LLM-Optimierung?

Eine exakte, hundertprozentige Erfolgsmessung ist momentan noch schwierig, da es noch keine speziellen Analytics-Tools dafür gibt. Aber es gibt verschiedene Indikatoren, mit denen Sie die Auswirkungen Ihrer Arbeit ziemlich gut einschätzen können.

Schauen Sie in Ihren Webanalyse-Tools nach dem Referral-Traffic von Diensten wie chat.openai.com oder perplexity.ai. Wenn der ansteigt, ist das ein sehr gutes Zeichen. Machen Sie außerdem manuelle Checks: Geben Sie relevante Prompts in verschiedene LLMs ein und schauen Sie, ob Ihre Marke oder Ihre Inhalte als Quelle auftauchen.

Auch ein Anstieg des direkten Traffics kann ein Hinweis sein. Nutzer navigieren oft direkt zur genannten Quelle, anstatt auf einen Link in der KI-Antwort zu klicken. Werfen Sie zusätzlich einen Blick auf Ihre Rankings für sehr spezifische Long-Tail-Fragen in der klassischen Suche – genau diese Fragen werden oft als Prompts für LLMs genutzt.

Möchten Sie Ihre Inhalte nicht nur für Suchmaschinen, sondern auch für die Zukunft der KI-Suche optimal positionieren? Das Team von Brand Rising entwickelt mit Ihnen eine maßgeschneiderte Strategie, die technische Präzision mit inhaltlicher Relevanz verbindet. Kontaktieren Sie uns für eine unverbindliche Analyse und erfahren Sie, wie wir Ihre digitale Sichtbarkeit nachhaltig steigern können.

0 Comments